Công cụ mã nguồn mở kiểm tra rò rỉ dữ liệu từ các hệ thống AI

Trong những năm gần đây, các nhà nghiên cứu bảo mật và quyền riêng tư đã chỉ ra tin tặc có thể tấn công suy luận mô hình AI, qua đó trích xuất thông tin nhạy cảm trong dữ liệu đào tạo

Ứng dụng trên điện thoại thông minh như chuyển lời nói thành văn bản, trợ lý Google vận hành nhờ nền tảng trí tuệ nhân tạo các hệ thống AI.

Hệ thống AI dùng để cải thiện chiến lược tiếp thị, giới thiệu sản phẩm, dịch vụ cho người dùng và đưa ra dự đoán về những rủi ro sức khỏe

Để các hệ thống AI có thể cung cấp thông tin chi tiết chúng ta phải đào tạo AI bằng các dữ liệu liên quan như thói quen mua hàng hoặc hồ sơ y tế của một người, những dữ liệu này có thể chứa thông tin nhạy cảm về một cá nhân.

Khi ‘khóa đào tạo’ mô hình AI kết thúc, nó không được lưu giữ lại bất kỳ dữ liệu đào tạo ban đầu nào để đảm bảo ngay cả khi tin tặc xâm nhập cũng không thể thu thập được bất kỳ thông tin nhạy cảm nào.

Các cuộc tấn công nguy hiểm từ tin tặc

Tin tặc có thể suy luận ra loại dữ liệu cụ thể đã sử dụng để đào tạo chương trình AI

Trong những năm gần đây, các nhà nghiên cứu bảo mật và quyền riêng tư đã chỉ ra tin tặc có thể tấn công suy luận mô hình AI, qua đó trích xuất thông tin nhạy cảm trong dữ liệu đào tạo. Tin tặc liên tục yêu cầu dịch vụ AI tạo thông tin, sau đó phân tích thông tin để tìm ra một mẫu hình.

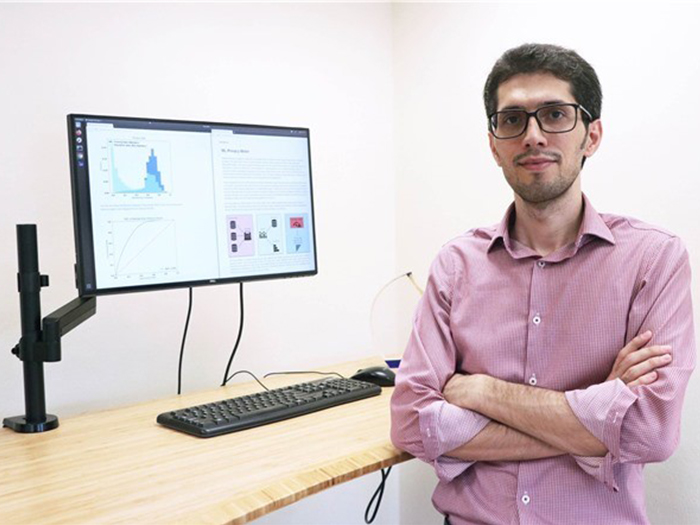

Các cuộc tấn công như vậy đang trở thành mối lo ngại của nhiều tổ chức trên toàn cầu. Như vậy, các công ty hiện không có cách nào để biết liệu các dịch vụ AI của họ có gặp rủi ro hay không vì hiện tại cũng không có công cụ hoàn thiện nào để chống lại kiểu tấn công này”, giáo sư Reza Shokri từ Đại học Quốc gia Singapore (NUS Computing) giải thích.

Giáo sư Reza Shokri cho biết

Giáo sư Shokri và nhóm của ông đã mất ba năm để phát triển công cụ đo quyền riêng tư của Máy học.

Để giải quyết vấn đề này, giáo sư Shokri và nhóm của ông đã phát triển một công cụ mã nguồn mở có thể giúp các công ty xác định xem các dịch vụ AI của họ có dễ bị tấn công suy luận như vậy hay không.

Công cụ đo quyền riêng tư của Máy học (ML Privacy Meter) giả lập tấn công suy luận, cuộc tấn công nhằm xác định xem một bản ghi dữ liệu cụ thể có phải là một phần của dữ liệu đào tạo mô hình hay không.

Bằng cách mô phỏng các cuộc tấn công, công cụ sẽ định lượng mức độ rò rỉ dữ liệu đào tạo của một mô hình AI, qua đó cho thấy nguy cơ xảy ra các cuộc tấn công khác nhau mà ở đó hacker sẽ cố gắng xây dựng lại toàn bộ hoặc một phần tập dữ liệu đào tạo.

Cuối cùng, công cụ này sẽ chỉ ra các khu vực dễ bị tấn công trong bộ dữ liệu dùng để đào tạo.

Từ mô hình hệ thống AI sẽ giúp định lượng những điểm yếu trong tập dữ liệu

“Khi xây dựng các hệ thống AI sử dụng dữ liệu nhạy cảm, các tổ chức nên đảm bảo rằng họ đã bảo vệ đầy đủ dữ liệu được xử lý trong các hệ thống đó. Công cụ của chúng tôi có thể giúp các tổ chức thực hiện phân tích hoặc kiểm tra rủi ro quyền riêng tư nội bộ trước khi triển khai hệ thống AI”.

Shokri nói. “Ngoài ra, các quy định như ‘Quy định chung về bảo vệ dữ liệu’ cũng yêu cầu phải đánh giá rủi ro về quyền riêng tư đối với dữ liệu khi sử dụng máy học. Công cụ của chúng tôi có thể hỗ trợ các công ty tuân thủ quy định này”.

Nguồn: khoahocphattrien.vn